平邑网站建设百度关键词搜索排名代发

工程安全监测无线振弦采集仪在建筑物中的应用

工程安全监测无线振弦采集仪是一种用于建筑物结构安全监测的设备,它采用了无线传输技术,具有实时性强、数据精度高等优点,被广泛应用于建筑物结构的实时监测和预警。下面将从设备的特点、应用场景和案例等方面详细介绍工程安全监测无线振弦采集仪在建筑物中的应用。

一、设备特点

1. 无线传输:工程安全监测无线振弦采集仪采用无线传输技术,数据传输更加方便快捷。无需线缆布局,只需要采集仪与指挥中心之间通过无线信号传输即可。

2. 实时数据:采用振弦传感器,实时检测建筑物的变形情况,数据更新频率高,可以及时发现建筑物结构变形情况,从而及时采取相应的应对措施。

3. 数据精度高:工程安全监测无线振弦采集仪具有高精度的水平和垂直测量精度,能够准确的测量建筑物的变形情况,从而为安全监测提供可靠的数据支持。

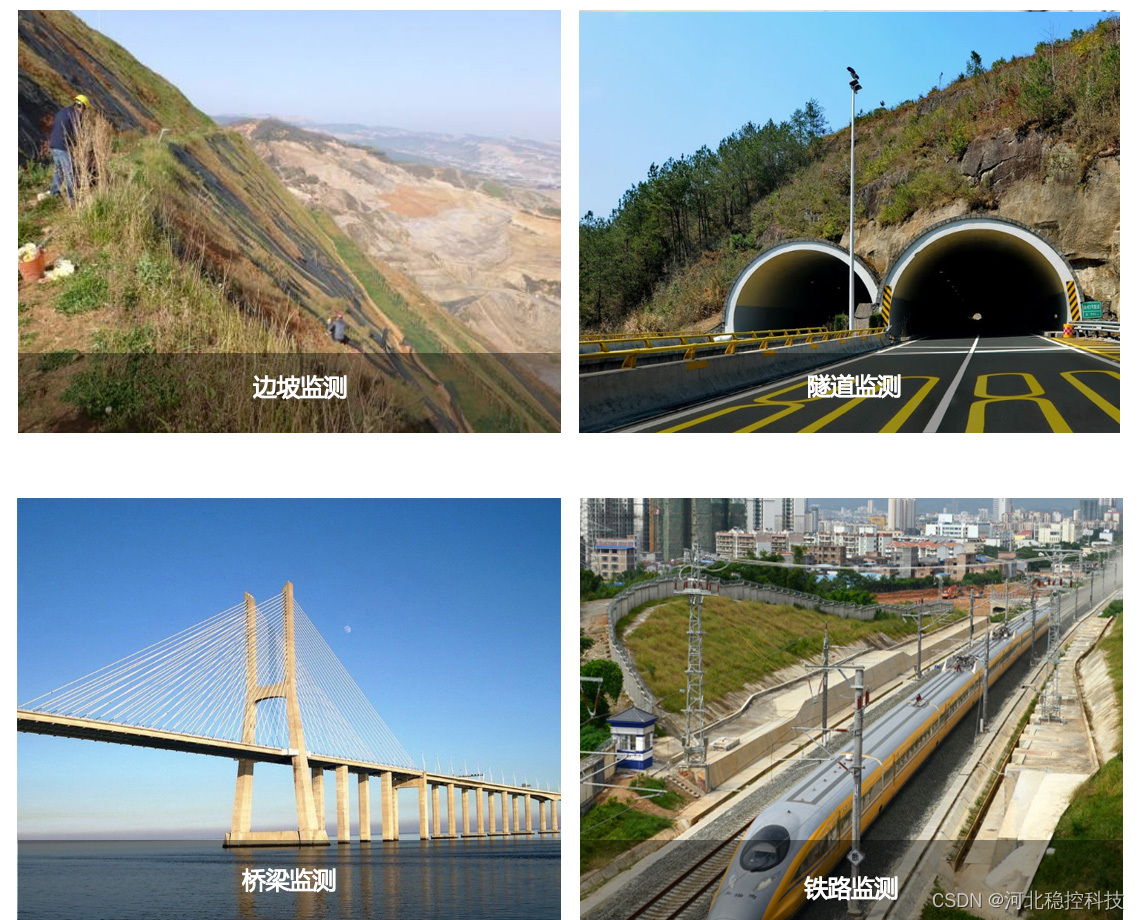

二、应用场景

1. 高层建筑:随着城市的发展,高层建筑越来越多,建筑的安全性显得尤为重要。工程安全监测无线振弦采集仪可以实时监测高层建筑的变形情况,从而及时预警和采取相应的措施。

2. 桥梁工程:桥梁工程的安全性也同样重要,工程安全监测无线振弦采集仪可以对桥梁的变形情况进行实时监测,从而及时发现并解决桥梁的结构问题,保障桥梁的安全。

3. 地铁隧道:地铁隧道结构是非常复杂的,地铁的安全性也是非常重要的。工程安全监测无线振弦采集仪可以对地铁隧道的结构变形进行实时监测,及时采取相应的应对措施,从而保证地铁的运行安全。

工程安全监测无线振弦采集仪在建筑物中的应用非常广泛,能够有效监测建筑物的变形情况,并保障建筑物的安全性。