让其他公司做网站的话术app香港账号

在推出中国首个类ChatGPT产品「文心一言」后,李彦宏在接受专访时断言,中国基本不会再出一个OpenAI了,「创业公司重新做一个ChatGPT其实没有多大意义,基于大语言模型开发应用机会很大,没有必要再重新发明一遍轮子。」

听完这话,已官宣「下一站是AI」的王慧文(美团联合创始人)、贾扬清(原阿里技术副总裁)、周伯文(原京东高级副总裁)、李岩(快手前 MMU 负责人)、闫俊杰(原商汤科技副总裁)等人,差点要怼回去,但又忍住了。

但搜狗创始人王小川可不能忍:历史上每次发生大的变化,都有创业公司的机会。很明显,创业公司会比大公司跑得快,为什么创业公司会不行?

跟百度向来不对付的王小川,还立下Flag:「我们有信心,在年底做出中国最好的大语言模型。」「最好的」自然意味着要碾压「文心一言」。

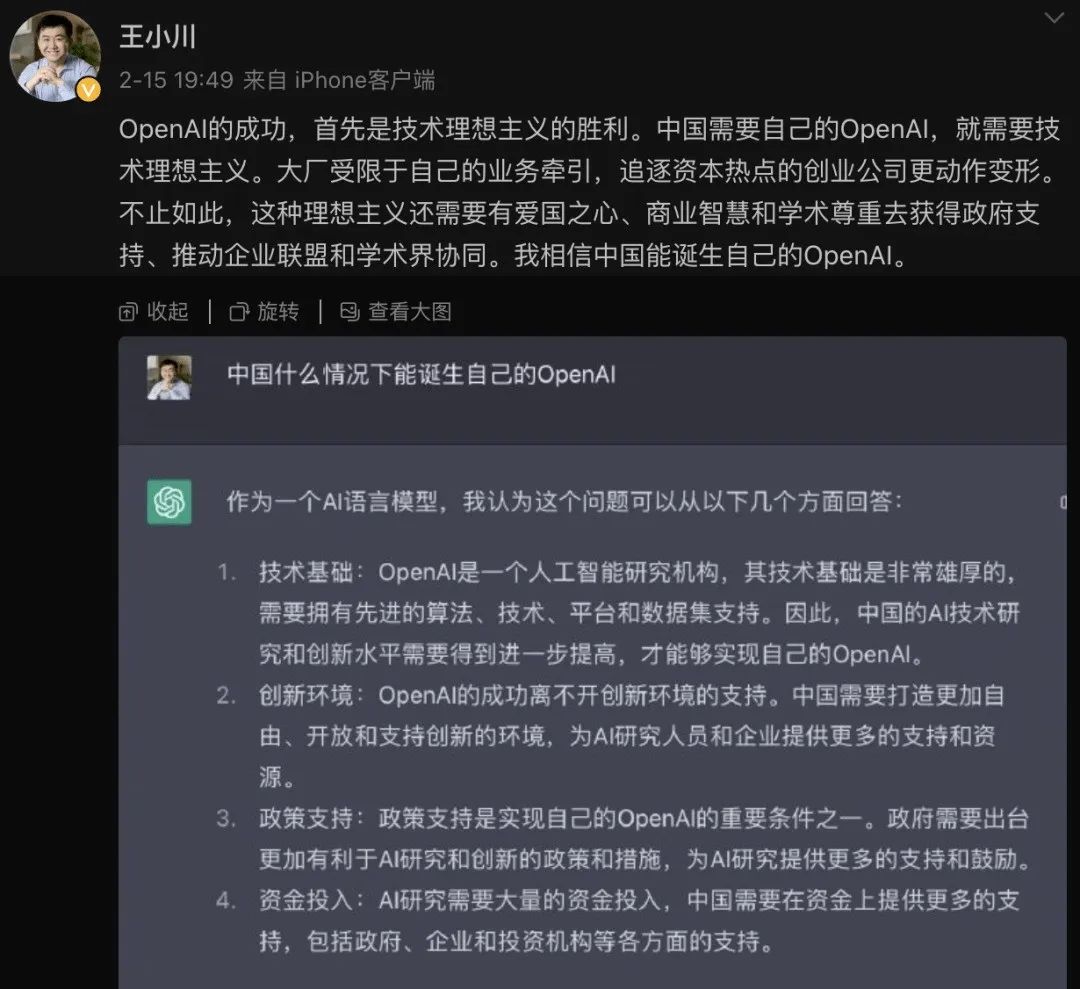

对于李彦宏「百度的文心一言和ChatGPT差距可能在一两个月左右」的说法,王小川就更不留情面了:你们可能采访的是平行宇宙里的他,不是我们这个世界里的。

他认为,「用时间衡量的话,OpenAI比我们应该领先三年时间是有的。之前我们说追上GPT-3.5,可能一年时间是有机会的。但人家已经到4了,还有5在训练当中,所以我觉得有三年。但这是很动态的,大家很努力就有可能快一些。」

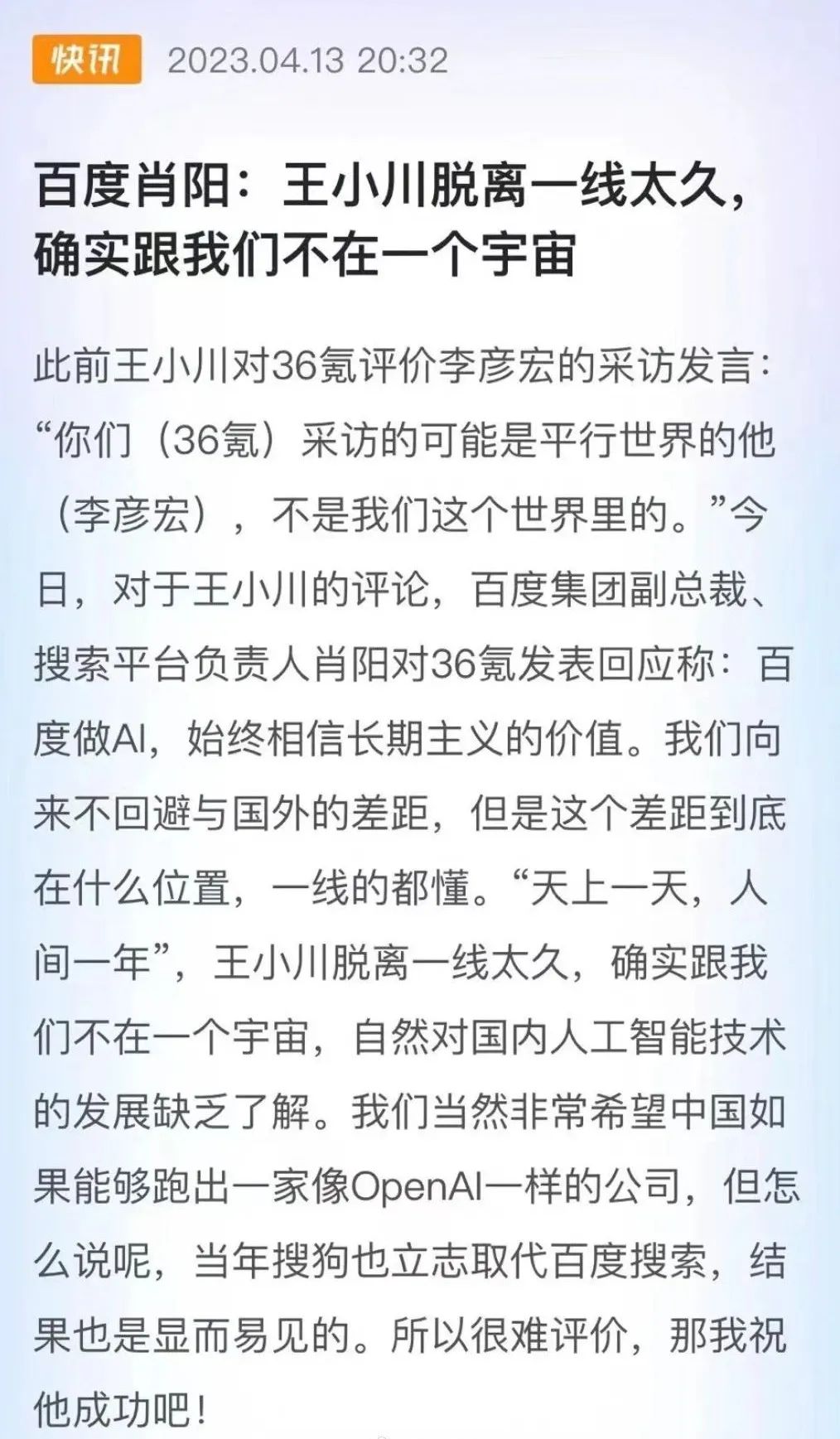

他的清华师弟、百度副总裁肖阳当即迎战:「‘天上一天,人间一年’,王小川脱离一线太久,确实跟我们不在一个宇宙,自然对国内人工智能技术的发展缺乏了解。」

肖阳还戳起了王小川的伤疤:「我们当然非常希望中国如果能够跑出一家像OpenAI一样的公司,但怎么说呢,当年搜狗也立志取代百度搜索,结果也是显而易见的。所以很难评价,那我祝他成功吧!」

王小川不甘示弱地再回击:「什么样的平行宇宙里,才能做到让一个脱离一线15年的人,去怼一个脱离一线1.5年的人。」

这一来一回,很有中国互联网圈几年前口炮横飞的既视感。

嗯,熟悉的味道又回来了。

01

说起来,中国互联网圈挺有意思,引领风骚的,来来回回就那么些个人。

这些人之间,渊源还挺深。写其中一个大佬的恩怨情仇,经常能串起一堆大佬来。

比如王兴和张一鸣,又如雷军和周鸿祎,都是你是风儿我是沙,早年相爱后相杀。

王小川逐梦互联网圈,也跟许多大佬交集甚密:马云、马化腾、李彦宏、张朝阳、周鸿祎……

这其中,他怼所有人的次数,加起来都没怼李彦宏跟百度多。

早在2005年百度在美股上市时,王小川就愤愤道:「我比李彦宏技术好,只是没有他命好」。

按照罗贯中式写法,这句话「译」成文言文就是:既生宏,何生川。

及至2013年,百度以19亿美元收购91助手后,王小川刀了李彦宏一把:百度已无法直接延续PC搜索的辉煌,急需手机助手类产品为未来各种无线搜索的可能性铺路。

他认为,百度最大的挑战是无线战略是否能够成功,如果成功,百度会回归千亿市值;如果失败,「百度就变成雅虎了」。

要知道,在2011年,百度市值还超越腾讯,成了中国互联网企业里的市值No.1。当时这样跳预言家,百度后槽牙都要咬碎了。

2017年2月,在百度还没从某场舆论危机里走出来时,王小川又在搜狗的财报媒体沟通会上箭头对准百度,称其是一家「没有战略的公司」。

4个多月后,百度在爱奇艺世界大会上的人工智能演讲PPT错别字连连,王小川借机调侃:百度更懂中文,百度总裁更懂百度。

当年8月,搜狗上市,网传李彦宏为百度新闻没推送相关消息发怒,王小川在微博调侃:「这图是真的。配个标题:这个没有!那个也没有!」

1年后,王小川在被问及「是否害怕人工智能方面声量特别大的百度」时,又表示:百度一年换一个战略,没什么好怕的。

依照「黑粉也是粉」的逻辑,这算不算爱得深沉?

王小川跟李彦宏倒不是没「和解」的机会。2010年,百度CTO李一男离职,李彦宏立马想到了王小川,王小川提出的要求是,自己过去可以,但百度必须全资收购搜狗。原本只想挖人的李彦宏,听到这话,放弃了。

到后来,王小川还曾回忆起这事,说自己曾有机会加入百度做CTO,但和李彦宏接触过后发现,李彦宏和自己完全「不来电」,于是没有加入百度。

2021年,在俞敏洪对话大咖的节目中,当时仍是搜狗CEO的王小川表示,如果自己在百度,那么现在百度会比现在「好一丢丢」。

可以说,曾因嫌弃高圆圆成绩不好、表示「不介意娶汤唯」被骂的王小川,在找女朋友这事上的上心程度都不及怼百度。

02

王小川跟百度,怎么就这么不对付呢?

原因也简单:搜狗跟百度,天生一对友(冤)商(家)。

百度的立身之本是搜索。自2000年成立之时起,百度就卡住了国内搜索引擎的最头部。

王小川2003年进搜狐,据说就接到了张朝阳的要求:「给你6个人头,灭掉百度。」

耗时11个月,王小川团队在2004年8月3日推出了搜索引擎搜狗。

只不过,在搜索领域,搜狗并没能赶超百度,倒是凭着「三级火箭模型」——浏览器、输入法、搜索引擎三位一体、形成闭环,曾在国内搜索市场居于次席。

你对标我,我也瞄准你,于是百度也推出了百度浏览器、百度输入法。

再到后来,错过移动互联网最早那波船票的百度,很早就开始发力AI,李彦宏成了AI布道者,预言「AI是互联网的下一幕」。

王小川也很早就盯上了AI。2011年,搜狗就在发力语音输入、跨语言信息处理等项目。

百度在AI动作连连,又是搭建大规模分布式计算平台、深度学习框架飞桨,又是推出图片检索、语音搜索,还发力自动驾驶,2017年推出小度。

它沿着「基础设施建设-大力拓展AI领域-AI+产业化-深入细分领域」的路径,深耕AI。

搜狗说,独秀不如众秀。2016年11月,在第三届世界互联网大会上,搜狗首次演示了基于神经网络的实时机器翻译技术;2017年,搜狗翻译通过AI技术将翻译错误率降低 10%-20%,错误率比肩谷歌同年发布的 Transformer 架构。

2018年11月,在第五届世界互联网大会上,搜狗又推出了全球首个全仿真智能AI主持人;2019年末问世的搜狗输入法10.0版,加入了「AI逐字校对」「AI长句预测」等功能。

在更多领域,双方都存在业务重合和直接竞争:百度有百家号,搜狗也有搜狗号;百度有度小满,搜狗则有「一点借钱」。

但搜狗终归是姓「搜」——搜狐的搜。

到后来,随着搜狗被腾讯35亿美元买下,王小川跟李彦宏在互联网的战事才告一段落。

原以为恩怨就此了结,可事实证明,冤家路窄,容易碰头,双方在「AI大模型」赛道再度相遇。

百模大战,百度获得先机。但王小川已经摆好了要大干一场的架势。

你在哪,我就在哪。某种程度上,王小川跟李彦宏也是「兄弟」。渣渣辉早就说了,是兄弟就来砍我。这份砍,背后也是「爱」得够深。

03

那这次王小川跟清华同门肖阳的隔空互怼,谁对谁错?

在国内大模型跟GPT产品的差距上,其实专家说法也莫衷一是。

同样进场的周鸿祎说,「中国和国外差距没有那么大,大概需要两年左右,有望赶上国外」。

注意了,他说的是「2年」和「赶上」。这其实是处在李彦宏跟王小川中间。

只能说,李彦宏是充分自信,王小川更「人间清醒」。

可当王小川说到「在年底做出中国最好的大语言模型」时,形象倒转了,比李彦宏更自信的似乎是他。

有经验积累当然是优势,可论参资金、管理和参数量、算力基础,攒够5000 万美元启动资金的百川智能,跟子弹更足的大厂仍有距离。

乍看起来,王小川比狂飙还狂。

可但凡是看过王小川履历的,又多会觉得,他还真有狂的底气。

虽然搜狗不算大厂,但王小川俨如现实版龙傲天。

1978年出生于成都的王小川,从小拿到的,似乎就是爽文剧本。

他自称「比李彦宏技术好」,也未必是夸下海口。

04

跟马斯克、马化腾、张一鸣一样,王小川从小就对计算机、编程兴趣浓厚。

兴趣是自己鸡自己的第一驱动。读小学四年级时,数学老师就经常骑自行车,带王小川去课外的计算机兴趣小组。

那时的王小川,放学后总是习惯钻进机房,课余时间还会看BASIC语言的书。

家人看他感兴趣,在他生日时买了台计算机给他,他由此成为了那个时代首批拥有电脑的人。

说他接触电脑的时间进度条击败了99.99%的中国人,都不为过。

1990年,12岁的王小川以入学考试第一名的成绩考入了成都七中,进入了综合数学实验班。

据称这班里还出了B站CEO陈睿、腾讯COO任宇昕、前蔚来汽车技术VP庄莉、前滴滴研究院院长何晓飞和蓝标COO熊剑。

之后的经历也有些逆天:在不到20岁前,他经历了屡获国内外大奖、被诺贝尔奖得主颁奖、被副总理接见、保送清华等高光时刻。

15岁拿到全国数学联赛一等奖;16岁加入中科院院士张景中的三人小组团队,负责在计算机上用吴文俊消元法实现初等几何定理的全部机器证明的工作,因此获得亿利达青少年发明奖,还被李岚清接见;18岁跟队友在第8届国际信息学奥林匹克竞赛IOI拿下四面金牌和团队第一(奥赛国家队队友中有拼多多现任CEO陈磊),被清华特招……

又是「上帝到底为他关上了哪扇窗」系列。

1999年,互联网企业ChinaRan对他开出8000元/月的兼职薪资。

仅7个月时间,王小川就和实习生将主推项目校友录做到了四千多万的日活,ChinaRan由此成了当时中国的第四大网站。

之后王小川又和8个人一起,花了3个月研发出一套搜索系统,他以偶像孙悟空的名字命名。

2000年,ChinaRen被张朝阳以3000万美元收购,被誉为「互联网教父」的张朝阳盯上了王小川,力邀他加入。

当时王小川已被保送读研,张朝阳问询后说,「 你上学多久我可以等你,你要多少钱我给你开。」

于是就是一段知遇与报恩的故事:2003年王小川研究生毕业,张朝阳迫不及待给他打了1个小时电话,催促他上岗,25岁的王小川很快成了搜狐技术总监,2年后成副总裁,31岁任搜狐CTO,32岁任搜狐CEO。

到了这时,除了没女朋友,王小川几乎有了世俗意义上超级人生赢家该具备的一切。

05

但命运也象征性地给王小川安排了些许挫折。

在2004年推出搜索引擎却干不过百度后,王小川经人点醒,做起了搜狗输入法。

2006年6月5日,搜狗输入法问世,虽然拼音输入、联想词和多样皮肤等很先进,但却不为大众所知——直到王小川将下载方式从搜狐门户网站转到了下载站和装机光盘渠道。

随之而来的,是搜狗输入法市场份额快速攀升,第二年是40%,第三年是79.7%。

紧接着,王小川提出了三级火箭模型的想法,想做浏览器,让浏览器、输入法一块给搜索导流。

然后,将业务重心放在视频上的张朝阳,并不许可这点——毕竟,搜狐视频2008年成为了北京奥运会的直播平台。

王小川不服,几天后,他的办公室门被人推开,撤职令下来,搜狗也不再归他管。

但王小川没放弃做浏览器的想法,也没选择以离开的方式自我成全,而是偷偷做。

两年后,搜狗浏览器面世,不久后就帮搜狐拿下10%的市场份额。张朝阳由此也开始成全王小川,将搜狗拆分,由他来独立管理。

从此以后,王小川就守在清华大学和搜狐大厦附近的五道口区域,带着搜狗做大。

2010年,周鸿祎看中搜狗,想买下搜狗,当时无心于搜索业务的张朝阳,也有意将搜狗易主。

但知道周鸿祎好斗性格的他,不愿意自家娃就这么被抱出去,他想到的招数是,引更有实力的阿里入场——阿里当时正跟百度闹掰,王小川连夜赶到杭州,和马云谈了40分钟,说服对方投资搜狗。

当年8月,阿里和搜狐召开发布会宣布,双方将成立合资公司共同发展搜狗,王小川出任新公司的CEO。

可「蜜月期」只持续了不到3年时间,在2013年阿里和百度和解、推出了自己的购物搜索引擎后,搜狐重新从阿里手中买回10%的股份,周鸿祎带着市值百亿的360再次找上张朝阳,他想彻底整合搜狗,价码是搜狐可以成为360占股30%的超级股东。

当时还在被抑郁症所困的张朝阳很心动,这时候,王小川故技重施,联系上了腾讯的刘炽平和马化腾。

王小川准备飞到深圳跟马化腾详聊,但在去机场时被张朝阳紧急喊回,迫于无奈,王小川折返,途中紧急跟马化腾通了个电话。

2013年9月,腾讯正式宣布入股搜狗,向搜狗注资4.48亿美元,并将搜搜和QQ输入法业务与搜狗现有业务进行合并。

跟腾讯打响「3Q大战」的周鸿祎很生气,给张朝阳发信息称:「搜狗姓王不姓张」。

在2017年8月上市后,搜狗迎来鼎盛期,但受互联网风口变化叠加疫情因素影响,搜狗很难再往上跃升。

张朝阳又动了卖掉搜狗股份的念头,接手的是腾讯,王小川这次没再想要阻止。

值得注意的是,2021年2月,在腾讯收购搜狗全部股份近半年后,王小川接受了俞敏洪访谈,被俞敏洪问到「你和张朝阳之间有没有一种隔阂的感觉?」时,王小川尴尬地说,「太敏感了,这个问题」。

8个月后,随着搜狗发公告宣布与腾讯完成合并,王小川宣布卸任搜狗CEO。

06

原以为王小川就此会深藏功与名,可自称「性格里有一面,是对世事变化懒得应对近乎迟钝」的他,最终还是在ChatGPT引发「数」业革命的当口复出江湖。

身为李彦宏之外的另一个AI布道者,这番选择其实也难言奇怪。

没了「太上皇」掣肘的王小川能否继续逆天,天知道。

至少就目前看,在隔空互怼中,他为刚创立不久的百川智能赚足了声量。

在大模型「诸侯争霸」的当下,这类互怼不可避免会引发许多争论。

在网上,有些人就不无嘲讽地说:国内大模型出师未捷,就先怼上了?

但怼怼也挺好,一团和气反倒不对劲。

想想几年前智能手机、网络外卖、网约车成风口那会儿,大佬们可没少怼过。

但大佬们敢怼敢吵,恰恰说明竞争激烈。有竞争就有冲突。

正是这样白热化的竞争,让中国互联网活力尽显。

只要不动用黑公关之类的「黑武器」,那对于整个社会就是好事。就让市场做他们的裁判好了。

马斯克怼比尔·盖茨、对扎克伯格、怼贝索斯,怼得还少吗?

反倒是互联网大佬们一个个变得沉默的时候,渐次意识到失去了很多东西的人们,开始纷纷怀念起大佬还能互怼的场面来。

因为那时大佬们还能展现个性、棱角与人味,而不是人形消声器。

好在,现在大佬们身上的「人味」慢慢回来了。

所以我们能看到,有的大佬在公司内部会上痛批各种问题,有的大佬怼起了友商。

在ChatGPT已标注了未来科技竞争朝向的背景下,大佬们高调互怼才是正常的,失声才是不正常——即便这类声音指向的是怼、骂、吹嘘。

一个多元的社会,一个开放的空间,一定是一个容得下互怼的地方。