广东省建设厅投诉网站冯耀宗seo

目录

性能测试的分类

为什么要进行性能测试呢?

性能测试曲线对比参数

虚拟用户数 vs 时间:

响应时间 vs 虚拟用户数:

吞吐量 vs 虚拟用户数:

错误率 vs 虚拟用户数:

资源使用情况 vs 时间:

组合视图

上图曲线图关键点介绍

性能测试的重要性主要体现在以下几个方面?

性能测试的分类

提到性能测试它的分类也挺多,包含负载测试,压力测试,尖峰测试,持久性测试,可扩展性测试,容量测试等。

性能测试用于确定系统的性能,以测量、验证系统在各种负载条件下的响应能力、效率、业务量扩展能力、稳定性等质量特性。性能测试的目标不仅是发现系统中的性能缺陷,而且可以推动性能调优来消除系统的性能瓶颈。

性能测试的工具不外乎商业的和免费的,商业性能测试国内有阿里云的性能测试服务PTS,收费也是比较可以的,国外的性能测试工具都是大家比较熟悉的LoadRunner。开源免费的工具也是使用频率比较高的Jmeter。

为什么要进行性能测试呢?

软件系统支持的特性和功能并不是唯一的问题,软件应用程序的性能,如响应时间、可靠性、资源使用情况和可扩展性很重要。

性能测试的目标不是发现错误,而是消除性能瓶颈,进行性能测试是为了向利益相关者提供有关其应用程序的速度、稳定性和可扩展性的信息。

性能测试首先体现在用户体验方面,用户对应用的响应速度有很高的期望,通过性能测试可以确保即使在高峰时段,也能提供良好的用户体验。

其次,性能测试为了发现系统的瓶颈,稳定性,可靠性,做出更合理的投资决策。这有助于避免过度配置或资源不足的情况。

然后,性能测试可以进行预防灾难性故障发生频率,有助于维护品牌形象并减少经济损失,可以进行成本效益分析。

最后,性能测试可以有效的进行商业决策,技术选型决定,包括何时升级现有设施、引入新技术或扩大规模以应对增长的需求。

性能测试曲线对比参数

性能测试中的压力曲线图是用来直观展示系统在不同负载条件下的表现的一种图形化表示方法。它通常会显示随着时间的变化,虚拟用户数量、响应时间、吞吐量等关键指标之间的关系。

虚拟用户数 vs 时间:

这种图表展示了测试过程中虚拟用户(VUs)的数量随时间变化的情况。对于阶梯式增加模型,你会看到一个逐渐上升的线条;如果是尖峰负载,则会出现明显的峰值。

响应时间 vs 虚拟用户数:

此图显示了随着虚拟用户数量的增加,应用程序响应时间的变化趋势。理想情况下,即使用户数量增加,响应时间也应保持在一个可接受的范围内。如果出现显著的增长点,说明可能存在瓶颈。

吞吐量 vs 虚拟用户数:

吞吐量是指单位时间内处理请求的数量。这张图帮助理解系统能够支持的最大并发请求数目。当接近或超过某个阈值时,吞吐量可能会开始下降,表明系统达到了其处理能力的极限。

错误率 vs 虚拟用户数:

该图显示了随着负载的增加,系统中发生的错误比例。高错误率可能是过载的结果,或者是代码问题的表现。

资源使用情况 vs 时间:

包括CPU利用率、内存占用量、磁盘I/O速率等服务器端指标与时间的关系。这些数据有助于识别硬件限制导致的问题区域。

组合视图

有时候,为了更全面地了解系统行为,可以将上述多种指标放在同一张图表上进行比较。例如,在同一坐标系下同时绘制虚拟用户数、平均响应时间和每秒事务数等信息。

制作这样的图表通常需要借助专业的性能测试工具如JMeter, LoadRunner, Gatling等,它们不仅能够生成脚本执行性能测试,还能提供丰富的报告和可视化功能来分析结果。

通过仔细分析这些图表,团队可以更好地优化应用性能,确保服务质量和用户体验。

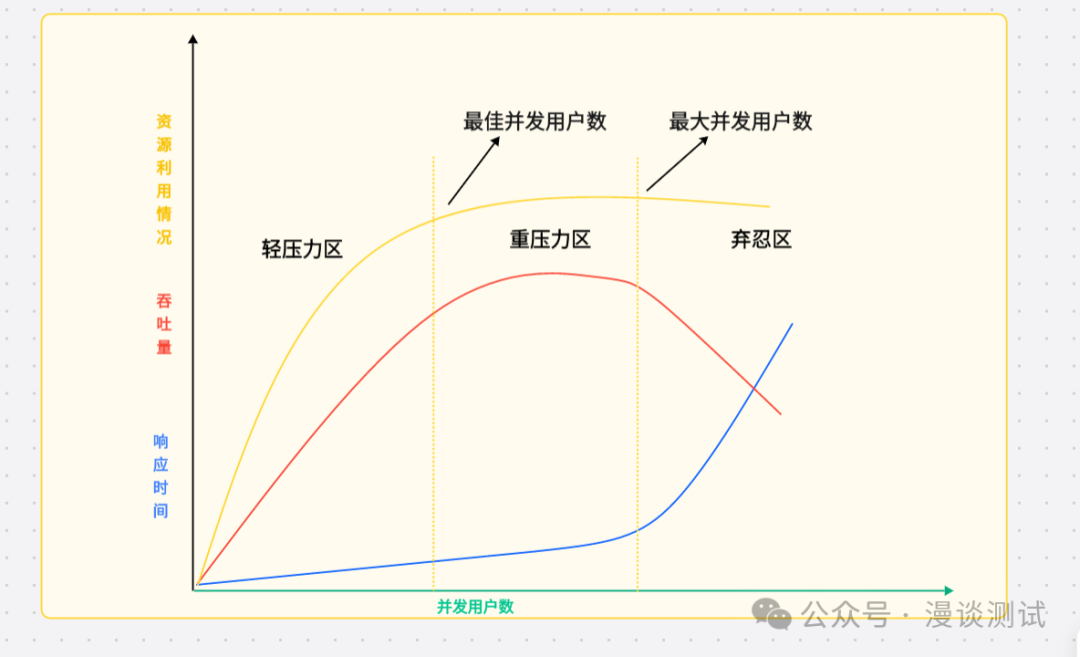

性能测试压力曲线模型这张图是一张非常经典的和测试相关的图片,叫做性能压⼒曲线图。

上图曲线图关键点介绍

横轴:并发的用户数,从左到右表现了 并发用户数的不断增长。纵轴:分别有三条曲线资源的利用情况,包括硬件资源和软件资源;吞吐量指每秒事务数;响应时间。

区域:曲线图主要分为 3 个区域,分别是:轻压力区,重压力区,弃忍区。

纵轴的三条曲线,每条曲线都是在性能测试过程中重点关注的信息:

并发用户数-资源利用情况曲线(橙色)

并发用户数-吞吐量曲线(红色)

并发用户数-响应时间曲线(蓝色)

而在随着用户数不停增大,很明显的可以看到图中有两个拐点:

第一个拐点:最佳并发用户数,在轻压力区和重压力区两个区域交界处的并发用户数。

代表最优并发用户数:既不会造成资源的浪费,也可以满足现有的需求。

第一个拐点到第二个拐点之间:最大并发用户数,在重压力区和弃忍区两个区域交界处的并发用户数平均响应时间会越来越高,而平均响应时间会直接影响到用户的使用体验。吞吐量和利用率曲线相较平稳。

第二个拐点:代表系统能承载的最大的并发用户数。一旦超过这个并发,代表服务器需要进行扩容。

过程分析:阶段 1 轻压力区:随着并发用户数的增长,资源使用率和吞吐量(TPS)会相应的增长,但是响应时间(RT)基本平稳,小幅递增;

阶段 2 重压力区:当并发用户数增长到一定值后,资源利用趋于饱和,吞吐量(TPS)增长明显放缓甚至停止增长,而响应时间(RT)却进一步增大。

阶段 3 弃忍区:如果并发用户数继续增长,软硬件资源占用继续维持在饱和状态(过饱和),但是吞吐量(TPS)开始下降,响应时间(RT)急剧递增。

综上所述,当系统的负载等于最佳并发用户数时,系统的整体效率最高,没有资源被浪费,用户也不需要等待;当系统负载处于最佳并发用户数和最大并发用户数之间时,系统可以继续工作,但是用户的等待时间延长,满意度开始降低,并且如果负载一直持续,将最终会导致有些用户无法忍受而放弃;当系统负载大于最大并发用户数时,将注定会导致某些用户无法忍受超长的响应时间而放弃。

所以性能测试的数据尽量保持在 CPU 利用率足够高,整个系统的吞吐负载可控。

性能测试的重要性主要体现在以下几个方面?

性能测试对于保障软件质量、提高用户体验、降低运营风险等方面都至关重要,它是软件开发生命周期中不可或缺的一环,尤其是在面对日益复杂的IT环境和技术挑战时更是如此。