转自:macOS重置虚拟桌面、macOS 虚拟桌面黑屏

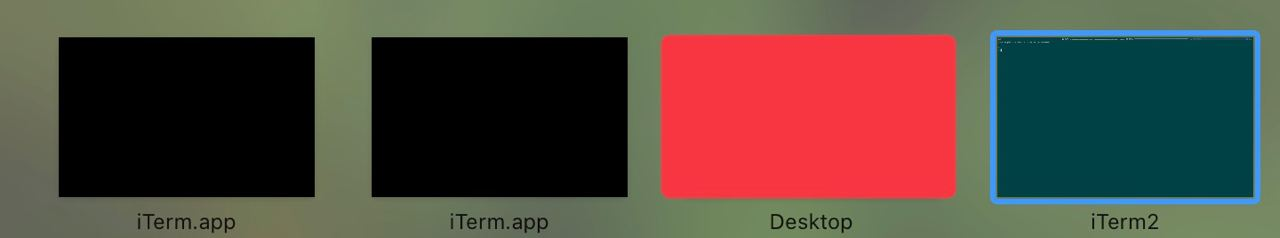

有几次出现如图的情况,以为是iTerm的问题,但是在关闭软件,重启之后,依旧无效。

后面经过网友告知,才知道是虚拟桌面的问题。

为了清理这个问题,有以下两种方法

法一:

在终端输入以下命令,会删除虚拟桌面文件,以及重启电脑

sudo rm ~/Library/Preferences/com.apple.spaces.plist

sudo restart法二

重置Dock初始状态

有的时候,上面的办法不能生效,你仍然会看到无法关闭的虚拟桌面顽固地出现在 misson control 的上方列表里。

此时你需要增加一条指令,然后再重启:

sudo rm ~/Library/Preferences/com.apple.spaces.plist

sudo rm ~/Library/Preferences/com.apple.dock.plist

sudo restart注意,重启后你的 Dock 会被重置为初始状态,自动隐藏或者Dock尺寸等等将会复原,你移动的、增删的 apps 都会复原到原始状态。这是强行重置虚拟桌面所付出的代价。

转自:macOS重置虚拟桌面、macOS 虚拟桌面黑屏