西安营销型网站制作价格竞价是什么意思

批量剪辑视频矩阵分发:

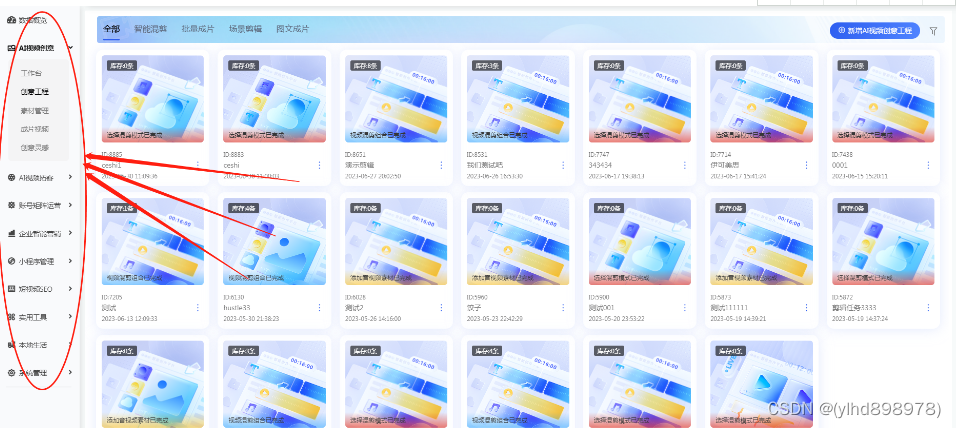

短视频seo主要基于抖音短视频平台,为企业实现多账号管理,视频分发,视频批量剪辑,抖音小程序搭建,企业私域转化等,本文主要介绍短视频矩阵系统+抖音小程序开发详细及注意事项

技术部署开发研发账号矩阵系统的开发成本取决于许多因素,包括系统规模、技术复杂性、功能需求、开发团队的规模和经验、开发周期、开发语言和工具等。

视频剪辑开发之 自研搭建数学建模 数学阶乘算法

一、 短视频矩阵系统的主要功能包括:

1)数据概览:账号,视频top10数据统计

(2)AI视频创意:原创视频批量剪辑,阶乘算法,去重原理

(3)同城拓客:线下门店曝光,POI团单转化

(4)账号矩阵运营:多平台多账号授权管理,抖音,快手,B站,小红书,好看视频

(5)企业号矩阵运营:抖音企业号多账号管理,私信,群聊消息接收,回复,意向客户管理,互动记录统计,智能客服7*24小时触达

(6)小程序管理:抖音小程序申请,配置,留资表单配置,线索收集,线索实时推送

(7)短视频seo:智能优化任务,账号,视频关键词排名查看

(8)AI智能助手,chatGpt接入,文案,脚本自动生成

$count_data['video_remain'] = $collect_data['cs_surplus'];

$count_data['video_create'] = $collect_data['cs_rest_num'];

$count_data['video_release'] = $collect_data['cs_scan_count'];

$count_data['video_download'] = $collect_data['cs_download_num'];

$count_data['video_total'] = $video_total;

$this->output['count_data'] = $count_data;

//视频混剪模式

$video_mixed_mode = plum_parse_config('project_mixed_mode', 'dydqt/project');

$this->output['video_mixed_mode'] = $video_mixed_mode;

//余量

$count_obj = new App_Helper_Count($this->sid);

$remain = $count_obj->checkFuncRemain('auth', 'item',true);

$this->output['remain_num'] = $remain['all']['remain'];

if ($this->front_module == 'eui') {

$this->displaySmarty('dspui/video/index.html');

} else {

$this->displaySmarty('dydqtshoppc/video/index.tpl');